HY Motion是腾讯推出的开源文本到3D动作生成AI模型,基于Diffusion Transformer (DiT) 架构打造,搭载超10亿参数,采用全阶段训练策略,覆盖200多种动作类别,可无缝集成至标准3D动画制作流程。

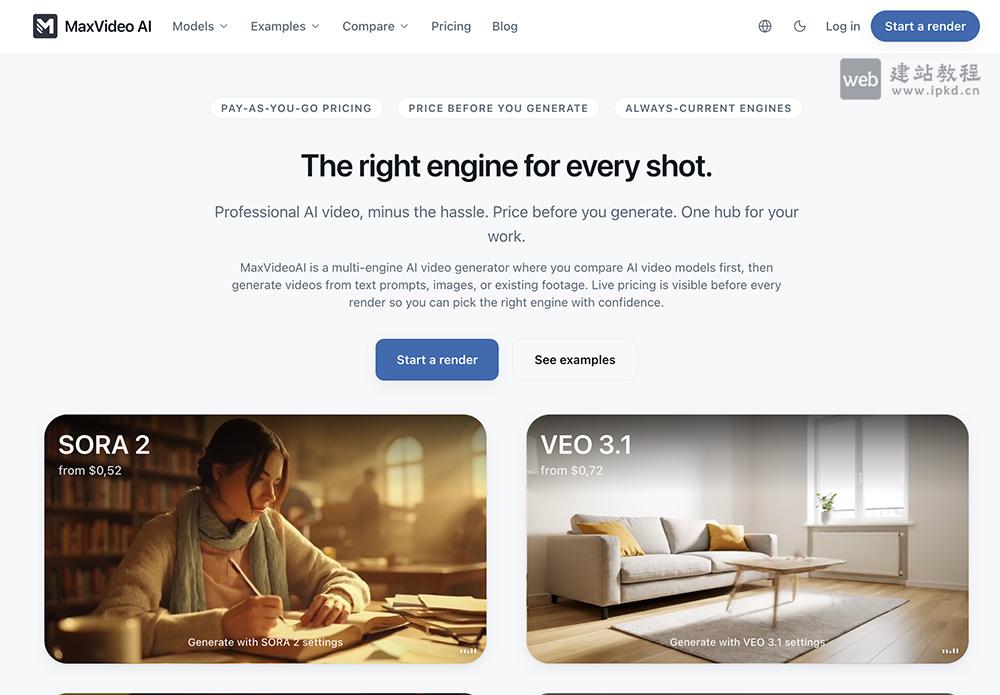

平台支持实时显示渲染价格,帮助用户精准控制成本、自主选择适配引擎;涵盖文本转视频、图像转视频、视频转视频全流程,彻底简化传统视频制作的繁琐步骤,定位为专业级AI视频生成平台,助力各类用户轻松实现创意落地。

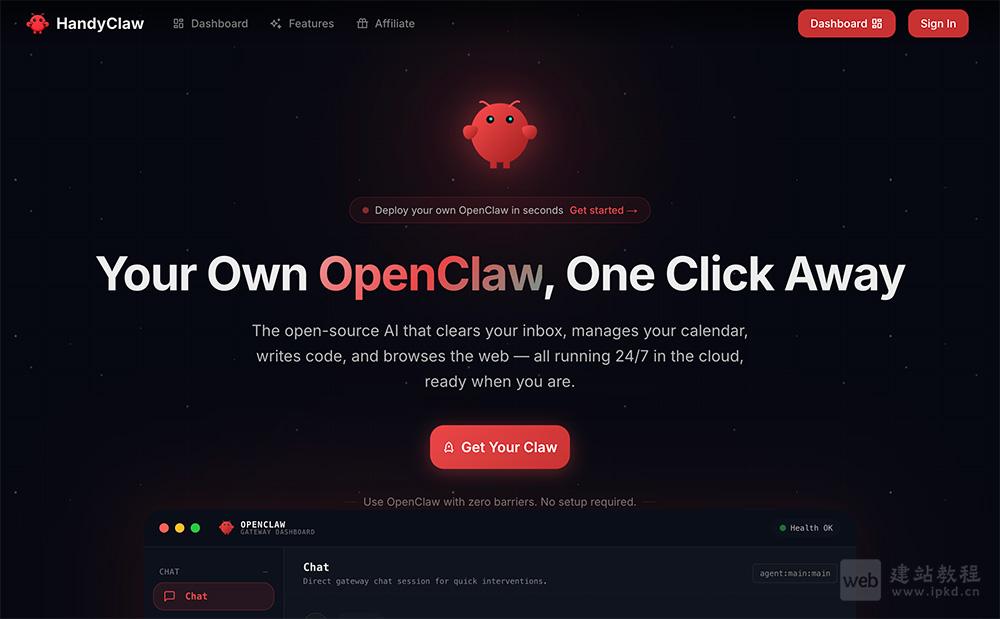

HandyClaw是专注于OpenClaw实例托管与管理的云端服务平台,提供Lite、Pro、Max三种套餐,年付订阅可立省20%,面向个人用户、开发者与小型团队,打造专业好用、上手零门槛的全托管AI助手服务。

用户可通过一句话调度多个专家级Agent协同工作,每个Agent自带丰富技能库;依托独立云上环境实现数据物理隔离,配备PPT生成、Excel分析、文档协同等百种能力,让AI从聊天伙伴进化为能干活的数字员工。

Xiaomi miclaw是小米基于自研MiMo大模型打造的系统级AI Agent,目前正于小米17系列进行小范围封测。它以系统应用身份深度运行,可调用50+项手机底层能力,实现从“对话交互”到“系统级执行”的跨越。

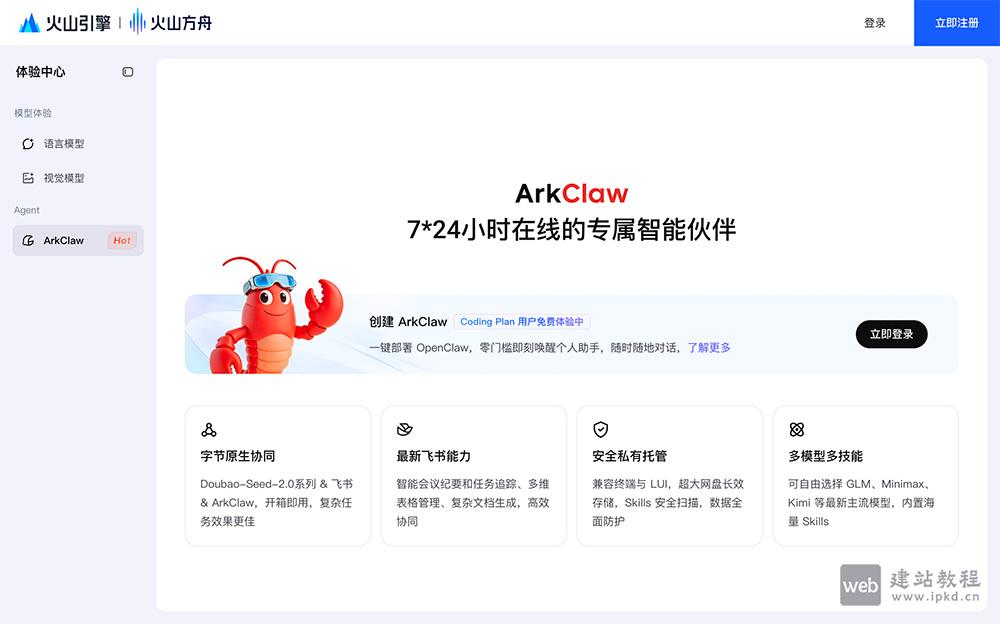

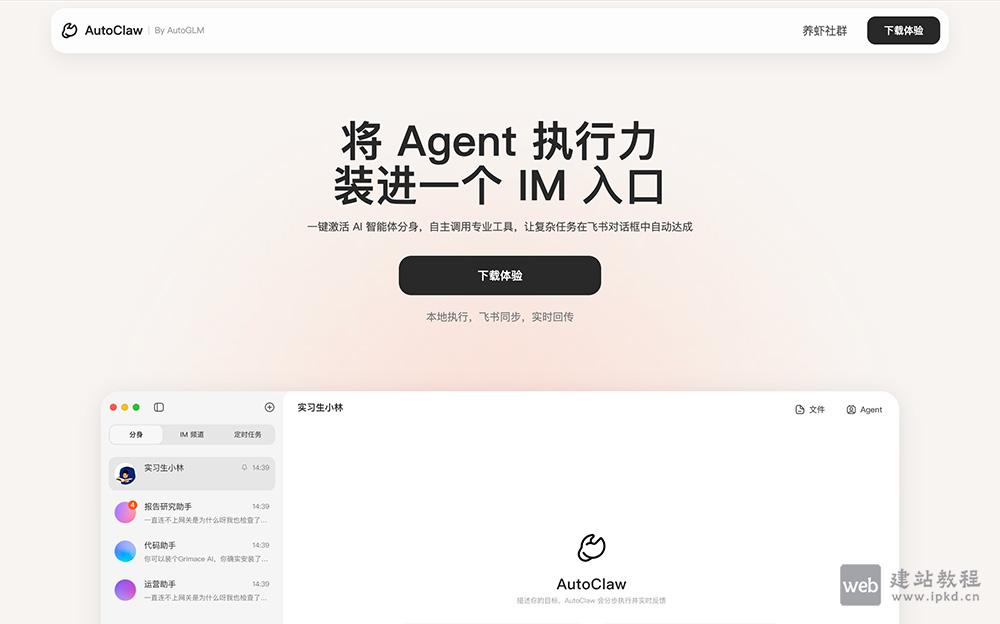

产品支持Doubao-Seed-2.0、Kimi、MiniMax、GLM等主流大模型灵活切换,深度集成飞书办公套件,可高效处理日程、文档、多维表格等办公任务,直连云端网盘实现文件极速传输,更内置Skills安全扫描机制,兼顾效率与企业数据安全。

平台内置50+预制Skills,覆盖办公、代码、营销等高频场景;集成Pony-Alpha-2专属模型与AutoGLM-Browser-Agent浏览器自动化能力,可自主完成复杂多步骤任务。同时开放接入DeepSeek、Kimi、MiniMax等第三方大模型API,以“人人养龙虾”为愿景,真正实现AI能力平民化、普惠化。

平台以零门槛、高质感、强创意为核心,降低图像合成与视觉创作难度,满足个人表达、电商营销、设计创意等多元需求。产品提供免费试用与订阅制付费方案,定位为面向个人用户与商业创作者的全能型AI图像合成工具。

Klingaio是全球领先的统一AI视频与图像创作平台,聚合业内顶级模型于一体化工作流,支持无缝调用Kling 3.0、Seedance 2.0、Veo 3.1等前沿模型,可一键生成带原生音频、精准可控、电影级1080P的高质量视听内容。

1ClickClaw是面向OpenClaw的一站式一键部署平台,专注降低AI机器人的使用门槛与部署成本,让任何人都能快速拥有专属AI助手。平台无需服务器、无需SSH、无需DevOps经验,即可实现快速上线与24小时不间断运行,完美满足普通用户与团队对私人AI助手的便捷使用需求。

AniShort是专为AI短剧打造的在线协作平台,采用层级化项目管理+画布式可视化编辑模式,帮助编剧、制作团队高效协同、快速落地创意,全面提升短剧制作效率,适用于剧情短剧、广告短片、AI生成剧等各类影视化内容创作。平台提供免费体验,致力于为内容创作者打造轻量化、高效率的协同创作环境。

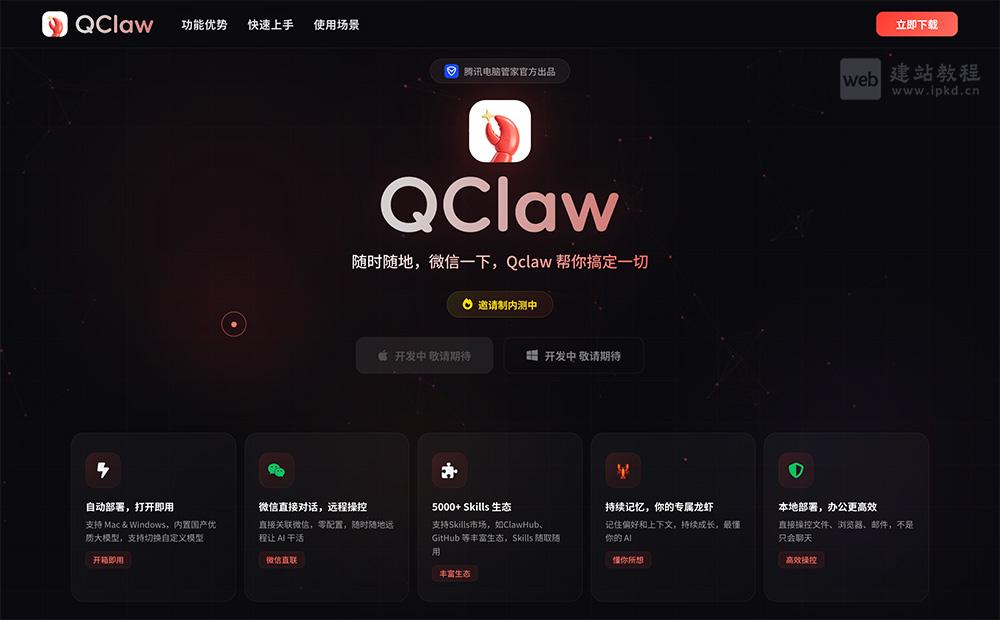

Qclaw特别适合追求高效工作、需要远程处理事务、频繁使用电脑与社交媒体的职场人士、自由职业者、内容创作者与开发者,通过远程控制+AI自动化,大幅提升工作效率与生活便捷度。

框架依托Transformer参数生成器,可根据输入动态合成专属LoRA权重,并即时注入冻结基座模型,无需微调即可实现实例级精准适配,从根本上解决传统微调的灾难性遗忘与任务冲突问题。HY‑WU在图像编辑等60+项任务中达到开源模型领先水平,为通用AI的个性化服务与持续学习开辟全新技术路径。

平台具备长期记忆、定时任务、文件处理等能力,可代用户完成房源搜索、机票预订、新闻摘要等日常任务;同时支持社区工具共享,可一键将自建工具分享给朋友使用,让AI像贴身私人助理一样全天候待命。

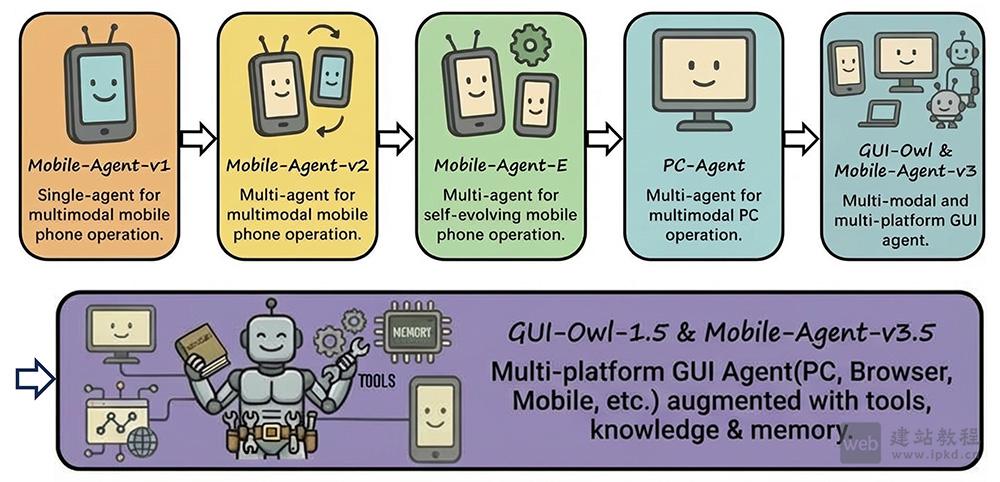

Mobile-Agent-v3.5在OSWorld-Verified、AndroidWorld、VisualWebArena等20+主流GUI基准测试中斩获开源领域SOTA性能,凭借混合数据飞轮、统一思维链合成、MRPO多平台强化学习三大核心技术,有效解决跨平台动作空间不一致、长程任务训练不稳定等行业痛点,为社区提供从基座模型到Agent框架的完整开源技术方案。