AvatarGO是一款由南洋理工大学S-Lab、上海 AI Lab,香港大学联合推出创新的4D人物交互生成和动画框架,旨在通过文本输入直接生成可动画化的 4D 人体-物体交互(HOI)场景。该框架利用预训练的扩散模型和大型语言模型(LLM),解决了现有方法在生成日常交互场景时面临的“交互位置”和“交互方式”两大挑战。

![]()

AvatarGO功能特点:

1、零样本生成:

AvatarGO 采用零样本方法,无需大规模交互数据即可生成高质量的 4D 人体-物体交互场景。

2、LLM 引导的接触重定向:

通过 Lang-SAM 技术,从文本提示中识别接触的身体部位,确保人体与物体之间空间关系的精确表示。

3、对应感知运动优化:

使用 SMPL-X 的线性混合蒙皮函数,为人体和物体模型构建运动场,确保在动画过程中保持空间对应关系,避免穿透问题。

4、连贯的合成运动:

AvatarGO 不仅生成连贯的合成运动,还在处理穿透问题时表现出更高的鲁棒性。

5、多样化的人体-物体对支持:

通过广泛的实验验证,AvatarGO 在多种人体-物体对和不同姿势上表现出卓越的生成和动画能力。

6、实时驱动与离线支持:

AvatarGO 支持仅需一台 2 核 4G 的电脑即可实时驱动数字人,且整个过程无需联网。

7、多终端兼容:

支持 Web 端、PC 客户端、安卓 APP 等多种集成方式,并兼容 Windows 和 Android 等操作系统。

AvatarGO应用场景:

– 虚拟现实与增强现实:生成逼真的 4D 交互场景,用于 VR/AR 应用。

– 数字人驱动:根据输入文本或音频实时驱动数字人,适用于客服、教育等领域。

– 影视制作:快速生成高质量的 4D 动画,降低制作成本。

AvatarGO 作为首个尝试将 4D 头像与物体交互合成的框架,为以人为本的 4D 内容创作开辟了新的可能性。

相关阅读文章

ClawWork模型使用入口,HKUDS开源的AI Agent经济生存基准测试框架

Nanobot:超轻量级个人AI助手,支持24小时实时行情分析、全栈开发、日程管理和个人知识库等场景

ViMax:香港大学数据科学实验室研发的端到端多智能体视频生成框架

Mini-o3:字节跳动 × 香港大学联合开源,攻克复杂视觉搜索难题

上面是“AvatarGO:一款由香港大学等联合推出4D人物交互生成和动画框架”的全面内容,想了解更多关于 IT知识 内容,请继续关注web建站教程。

当前网址:https://ipkd.cn/webs_17784.html

AvatarGO(官网) 打不开万能教程:

1、微信/QQ内打不开:

把链接复制到系统浏览器再访问,微信/QQ内置页常自动拦截第三方站。

2、浏览器报“违规”:

部分国产浏览器的误拦截,换用系统原生浏览器即可:iPhone→Safari,安卓→Edge、Alook、X、Via 等轻量浏览器,均不会误屏蔽。

3、网络加载慢或空白:

先切换 4G/5G 与 Wi-Fi 对比;可以尝试使用网络加速器,将网络切换至更稳定的运营商。另外,部分网站可能需要科学上网才能访问,如Google、Hugging Face等一些国外服务器的网站(不推荐)。

AvatarGO数据评估

【AvatarGO】浏览人数已经达到 454 次,如你需要查询该站的相关权重信息,建议直接到 5118、爱站或Chinaz 搜索域名「yukangcao.github.io」查看最新权重、收录与关键词排名;若需精确的 IP、PV、跳出率等核心指标,仍需与站长沟通获取后台数据。总体判断时,可把访问速度、索引量、用户停留体验等因素一起纳入考量,并结合自身需求再做决策。

猜你喜欢

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

帝国cms功能之整合discuz7.2后积分同步的问题

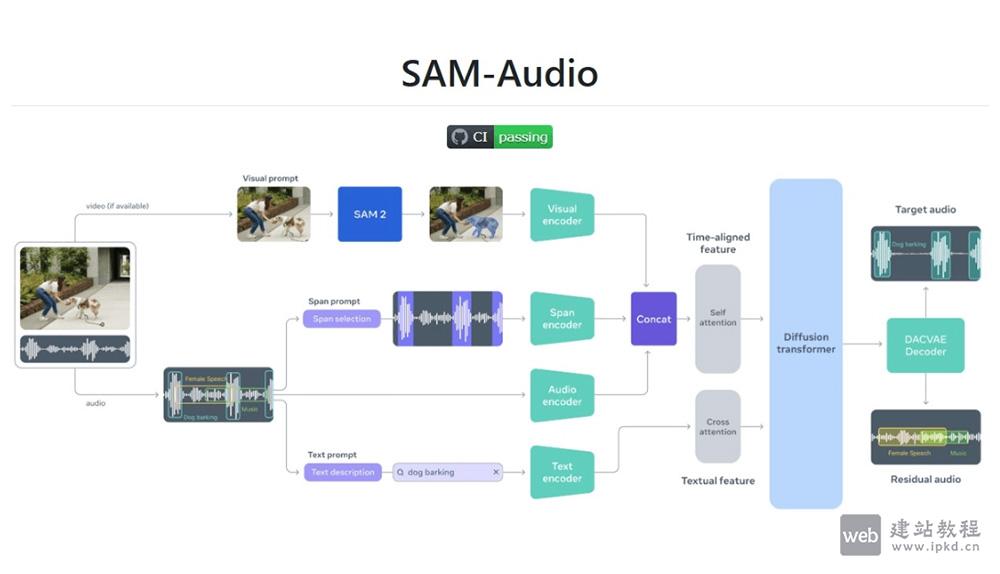

帝国cms功能之整合discuz7.2后积分同步的问题  SAM Audio:Meta开源多模态音频分割模型,精准分离复杂声音场景

SAM Audio:Meta开源多模态音频分割模型,精准分离复杂声音场景  帝国CMS7.0功能之专题大更新,功能更强大,制作

帝国CMS7.0功能之专题大更新,功能更强大,制作