MMBench是一款多模态基准测试工具,由上海人工智能实验室、南洋理工大学、香港中文大学、新加坡国立大学及浙江大学联合研发。该基准构建了一套从感知到认知的逐级细分评估流程,覆盖20项细粒度能力维度,数据集包含约3000道单项选择题,均源自互联网及权威基准数据集。

FLM-Audio是由北京智源人工智能研究院携手Spin Matrix、新加坡南洋理工大学联合研发的原生全双工音频对话大模型,全面支持中英双语交互,凭借突破性技术架构与训练范式,重新定义智能语音对话的自然流畅体验。

StoryMem是字节跳动与南洋理工大学联合研发的开源多镜头视频生成框架,核心解决AI视频生成领域长期存在的跨镜头一致性痛点。它创新性地引入显式视觉记忆机制,将传统单镜头视频扩散模型升级为专业多镜头叙事工具;

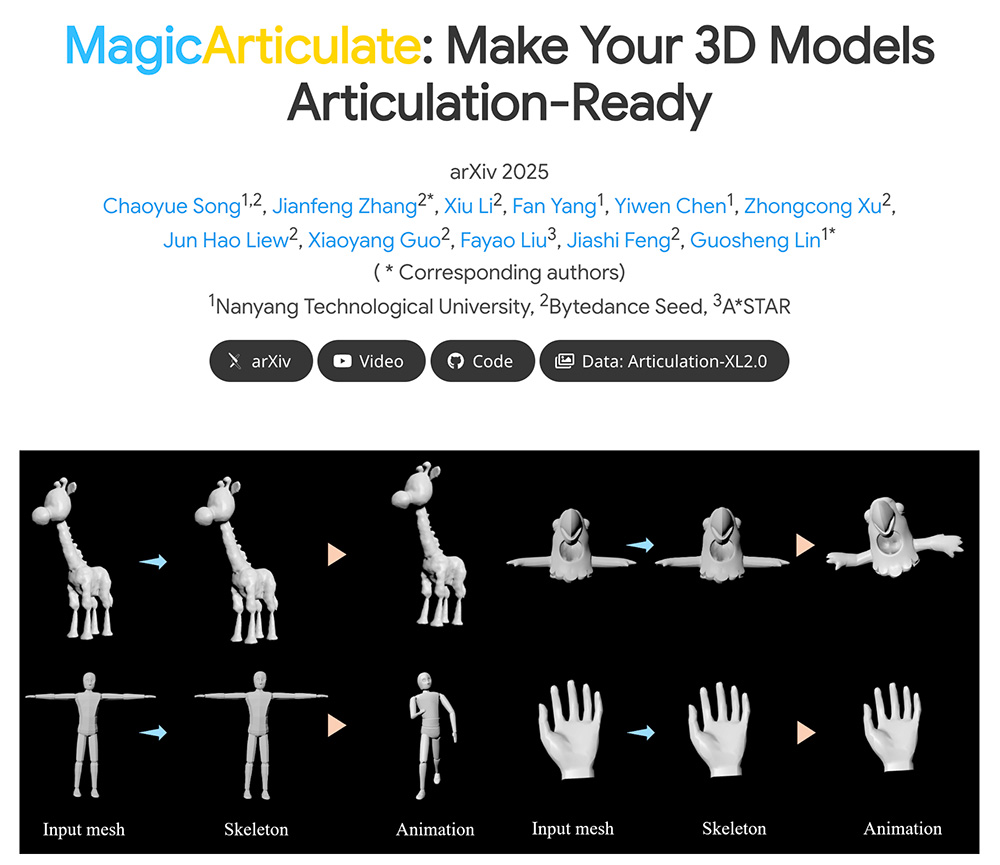

MagicArticulate 通过自动骨架生成和蒙皮权重预测,显著提升了静态 3D 模型的动画化效率。它结合大规模数据集和先进的自回归 Transformer 模型,为 3D 内容创作提供了高效且高质量的解决方案。

AvatarGO 是一个创新的 4D 人物交互生成和动画框架,它通过零样本方法和大型语言模型(LLM)引导的接触重定向技术,实现了从文本到动画的无缝转换,解决了传统方法在交互位置和方式上的难题。

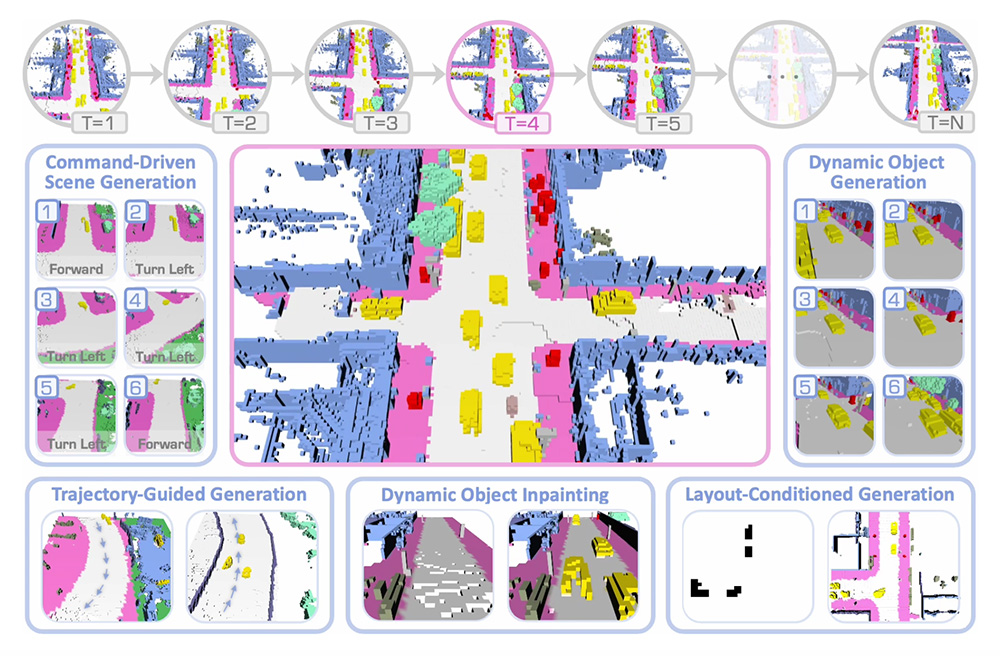

DynamicCity是一款专注于生成具有语义信息的动态 LiDAR 场景,能够处理大规模空间(80×80×6.4 m³)和长序列(最多 128 帧)的数据。该框架通过在潜空间显式建模场景的空间布局与动态变化,并借助扩散模型直接生成高质量的动态场景。