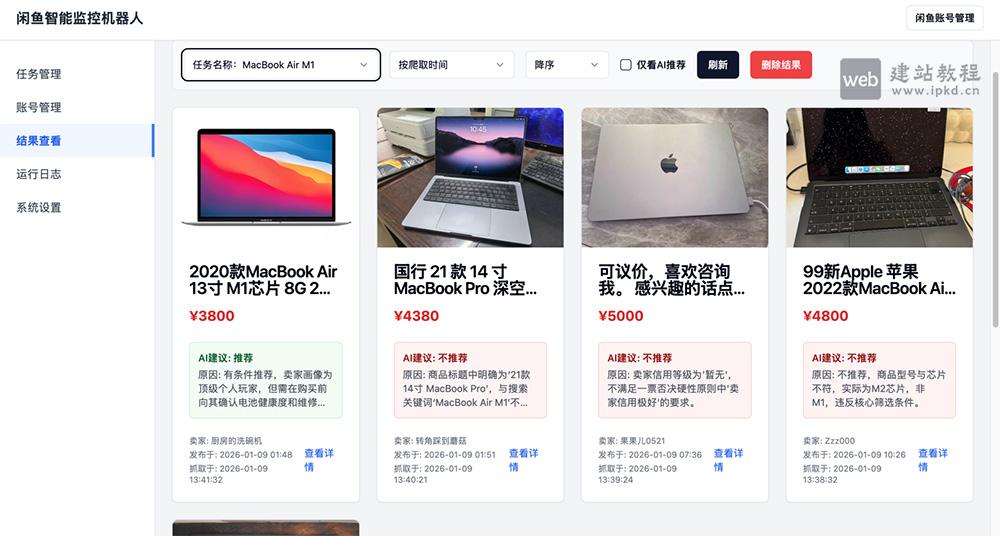

闲鱼智能监控机器人基于Playwright + 多模态AI打造,是面向闲鱼玩家与商家的一站式商品监控工具。支持实时/定时监控商品、AI智能过滤无效信息,精准匹配目标商品后秒级推送通知,搭配可视化Web管理界面,无论是个人蹲捡漏好物,还是商家监控竞品动态,均可高效落地。

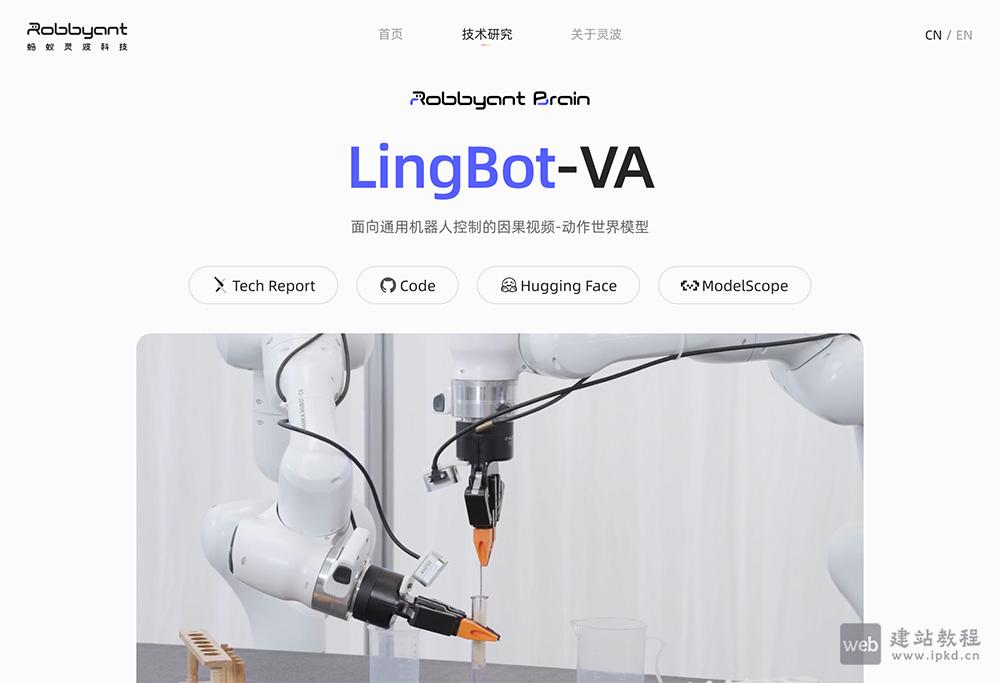

LingBot-VA是蚂蚁灵波科技开源的全球首个面向通用机器人控制的因果视频-动作世界模型,模型具备极致的数据效率,仅需30-50次真实演示即可习得新技能,在长程任务执行、数据高效后训练、跨场景泛化能力上,显著优于业内主流基准模型,为通用机器人的智能控制提供核心技术支撑。

UnifoLM-VLA-0是宇树科技开源的通用视觉-语言-动作(VLA)大模型,基于Qwen2.5-VL-7B架构完成持续预训练,核心通过融合2D/3D空间感知、轨迹预测等多维监督信号,实现从视觉语言理解到具身智能体的技术进化。