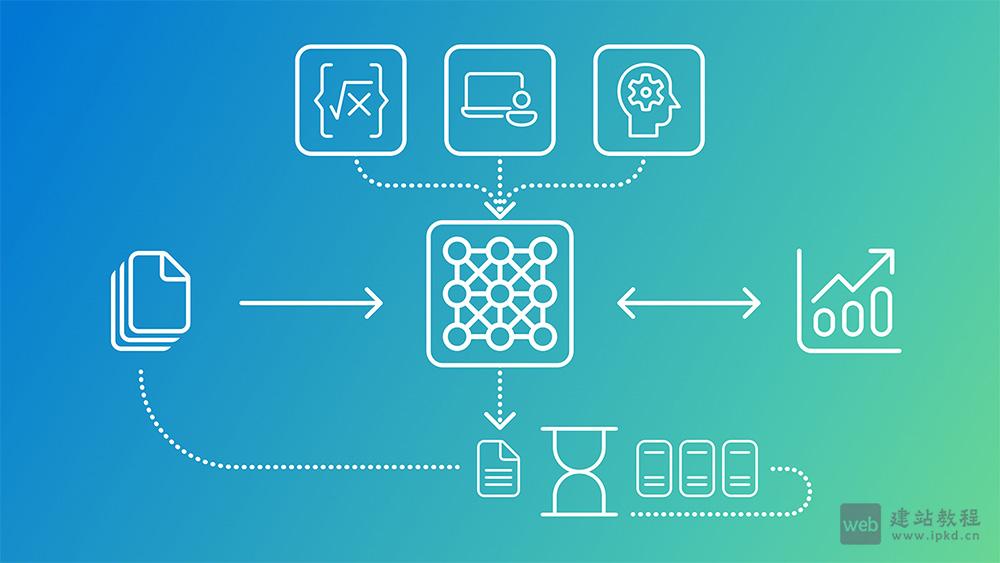

JoyAI-LLM-Flash是京东在Hugging Face正式开源的最新大语言模型,标志着其在高效、低成本、智能体友好型AI基础模型领域的重大突破。该模型采用混合专家(MoE)架构,总参数达480亿,而每次推理仅激活30亿参数,既能保持强大的模型能力,又能显著降低计算开销。模型基于20万亿token的高质量文本完成预训练,重点强化了前沿知识理解、逻辑推理、代码生成及智能体(Agent)协作四大核心能力,适配多场景实用需求。

JoyAI-LLM-Flash核心技术创新:

1、FiberPO:纤维丛理论赋能强化学习

京东团队创新提出全新优化框架FiberPO,首次将微分几何中的纤维丛理论(Fiber Bundle Theory)应用于强化学习策略优化。该方法通过构建参数空间的几何结构,有效提升策略更新的稳定性与收敛速度,尤其适用于复杂任务中的长期规划,为模型高效学习提供了底层支撑。

2、Muon优化器 + 稠密MTP双效加持

Muon优化器:一款新型自适应优化算法,在大规模模型训练过程中展现出更强的数值稳定性,有效避免训练过程中的异常波动,保障训练效率。

稠密MTP:支持模型在单次前向传播中并行预测多个未来token,大幅提升训练与推理的效率,缩短任务处理周期。

两者协同作用下,模型推理吞吐量较非MTP版本提升1.3x–1.7x,同时成功缓解了传统MoE模型在规模扩展时常见的训练震荡问题,实现效率与稳定性的双重提升。

3、训练-推理协同设计,兼顾性能与成本

JoyAI-LLM-Flash从底层架构设计阶段,就重点考量部署成本与实际应用场景适配,通过三大核心举措,实现低延迟、高吞吐、低成本的线上服务能力,特别适合需要高频调用的智能体系统或实时应用:

– 激活参数最小化,降低推理时的计算负载;

– 借助MTP技术加速token生成,提升响应速度;

– 优化器与硬件深度对齐,最大化利用硬件性能。

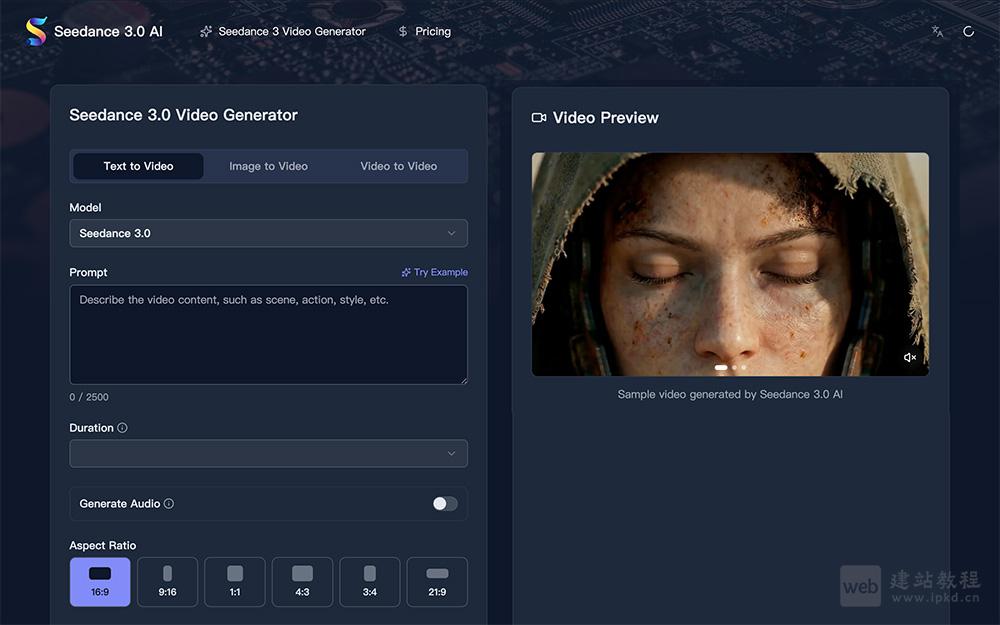

JoyAI-LLM-Flash专为智能体场景优化:

不同于通用大语言模型,JoyAI-LLM-Flash在训练阶段便深度融入智能体核心能力,针对性优化工具使用、环境交互、自主决策等关键场景,具体优势如下:

1、完美支持函数调用(Function Calling)与工具链集成,可灵活对接各类实用工具;

2、强化多步推理与错误恢复机制,提升复杂任务处理的准确性与容错率;

3、在代码生成、API调用、任务分解等相关基准测试(benchmark)中表现优异,能力突出。

JoyAI-LLM-Flash应用场景:

1、企业级智能客服:适配高并发场景,同时凭借低成本优势,降低企业服务部署成本;

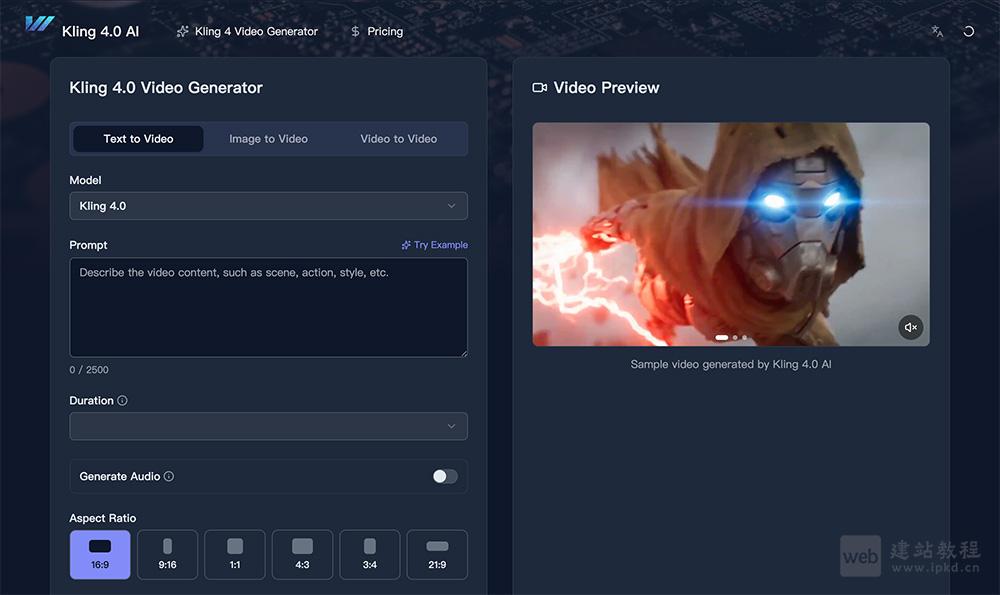

2、自动化编程助手:高效完成代码生成、调试等任务,提升开发效率;

3、多智能体协作系统:适配TinyClaw、OpenClaw等类平台,支持多智能体协同完成复杂任务;

4、实时数据分析与报告生成:快速处理数据、生成可视化报告,助力高效决策;

5、边缘设备轻量化AI推理:配合量化技术,可部署于边缘设备,实现本地化高效推理。

相关阅读文章

Hugging Face模型库官网入口,AI模型的GitHub

Hypernova-60B-2602模型,Multiverse发布的免费开源压缩大模型

LFM2-24B-A2B模型使用入口,LiquidAI正式发布的LFM2家族模型

Grok 4.20模型使用入口,采用约3T参数的MoE架构,支持256K tokens超长上下文窗口

Voxtral Mini 4B Realtime 2602:Mistral AI正式开源的实时流式语音识别模型

上面是“JoyAI-LLM-Flash模型使用入口,京东AI开源的最新大语言模型”的全面内容,想了解更多关于 AI项目和框架 内容,请继续关注web建站教程。

当前网址:https://ipkd.cn/webs_31074.html

Hugging Face模型库(官网) 打不开万能教程:

1、微信/QQ内打不开:

把链接复制到系统浏览器再访问,微信/QQ内置页常自动拦截第三方站。

2、浏览器报“违规”:

部分国产浏览器的误拦截,换用系统原生浏览器即可:iPhone→Safari,安卓→Edge、Alook、X、Via 等轻量浏览器,均不会误屏蔽。

3、网络加载慢或空白:

先切换 4G/5G 与 Wi-Fi 对比;可以尝试使用网络加速器,将网络切换至更稳定的运营商。另外,部分网站可能需要科学上网才能访问,如Google、Hugging Face等一些国外服务器的网站(不推荐)。

猜你喜欢

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

Android系统之Service生命周期是什么?

Android系统之Service生命周期是什么?