Voxtral-Mini-4B-Realtime-2602是Mistral AI正式开源的实时流式语音识别模型,仅40亿参数,即可在保持高精度的前提下,实现500ms以内超低延迟,并原生支持中文等13种语言。

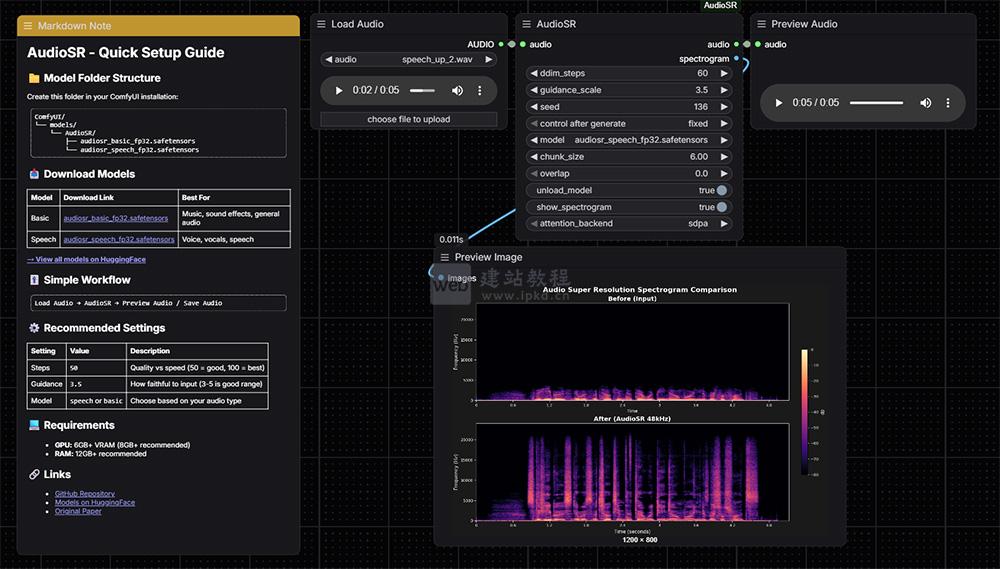

ComfyUI AudioSR是专为ComfyUI打造的原生音频超分辨率处理节点,基于先进的潜在扩散模型AudioSR研发,核心能力是将任意低质量音频(低采样率、低码率)上采样至48kHz标准音质,同时精准增强高频细节、修复压缩失真问题,实现音频清晰度、饱满度的显著提升,完美适配ComfyUI音频处理工作流。

JoyAI-LLM-Flash是京东在Hugging Face正式开源的最新大语言模型,该模型采用混合专家(MoE)架构,总参数达480亿,而每次推理仅激活30亿参数,既能保持强大的模型能力,又能显著降低计算开销。

Ming-omni-tts核心依托团队自研技术,采用12.5Hz连续分词器,搭配逐块压缩技术,在坚守高音质输出的基础上,大幅提升推理效率,推理帧率可低至3.1Hz,有效降低延迟。同时,模型具备强劲的文本正则化能力,能够准确、自然地朗读复杂数学公式与化学方程式,完美适配专业内容播报、教育科普等对文本解析要求较高的场景。

Ovis2.6-30B-A3B核心升级为MoE架构,实现300亿总参数与仅30亿激活参数的平衡,兼顾大模型能力与小模型推理成本;MoE架构提效降本、64K长上下文+高清图像处理、主动式图像思考、强化的OCR/文档/图表理解。

Nanbeige4.1-3B以30亿小参数规模打破性能桎梏,通过多轮优化实现推理、对齐、智能体能力全方位提升;为小模型生态提供全能化发展新范式,保留轻量化部署优势的同时,具备比肩大模型的核心性能。

Ring-2.5-1T是蚂蚁集团推出的全球首个万亿参数混合线性注意力开源思维模型,核心实现“想得深、推得快、做得久”;模型开源且轻量化,重新定义万亿参数模型的性能边界,为通用人工智能体研发奠定关键基础。

Ming-flash-omni-2.0是蚂蚁集团开源的SOTA全模态大模型,MoE架构兼顾性能与效率,核心实现图像/视频/音频/文本的统一理解与生成;核心适配智能教育、内容创作、文博数字化、实时交互娱乐、智能图像处理等场景。

作为一款专为复杂场景设计的高性能大型语言模型,INTELLECT-3聚焦推理、数学、编码三大核心场景,原生支持工具调用与链式推理能力,旨在为用户提供一流的文本生成、多步骤问题解决能力,适配学术研究、软件开发、专业咨询等高端需求场景。

该模型以TheDrummer/Cydonia-24B-v4.3为基础,通过llama.cpp工具将原始模型转换为Q8_0、Q6_K、Q4_K等多种量化格式,在显著压缩模型文件体积的同时,最大限度保留原版模型的核心质量,让这款24B参数的大模型能够在消费级硬件上高效运行,大幅降低大模型的部署与使用门槛,适配更多轻量化应用场景。

Thedrummer Magidonia 24B V4.3 GGUF作为一款24B参数的高性能大语言模型,其量化版本覆盖了从高精度到高压缩比的全维度选择,无需高端算力支撑,即可轻松在消费级硬件上实现部署与推理,大幅降低了大模型的使用与落地门槛。

作为一款经过专业量化的网络安全专用模型,其核心定位是贴合网络安全从业者的实际工作场景,简化复杂任务的操作流程,无需高端硬件支撑,即可快速调用模型能力,完成各类网络安全相关任务,兼顾实用性、易用性与专业性。

Qwen2.5 Coder 1.5B Instruct Gensyn Swarm Graceful Slender Toucan是一款基于Hugging Face Transformers库构建的模型,目前其核心功能、技术架构及具体应用用途,暂未公布详细信息,需等待模型发布者进一步补充完善。

Step 3.5 Flash是阶跃星辰全新开源的基座模型,专为Agent智能体场景打造,采用稀疏MoE架构,实现性能与效率的双重兼顾:模型总参数达1960亿,推理时每token仅激活110亿参数,推理速度峰值高达350 TPS,同时支持256K超长上下文窗口,在数学推理、代码生成及各类Agent复杂任务中,性能媲美行业顶级闭源模型。