ZUNA基于掩码扩散自编码器(Masked Diffusion Autoencoder)架构构建,在近200万通道小时的公开脑电图数据上完成大规模预训练,深度习得脑电信号的通用先验规律,实现对信号的理解式处理。

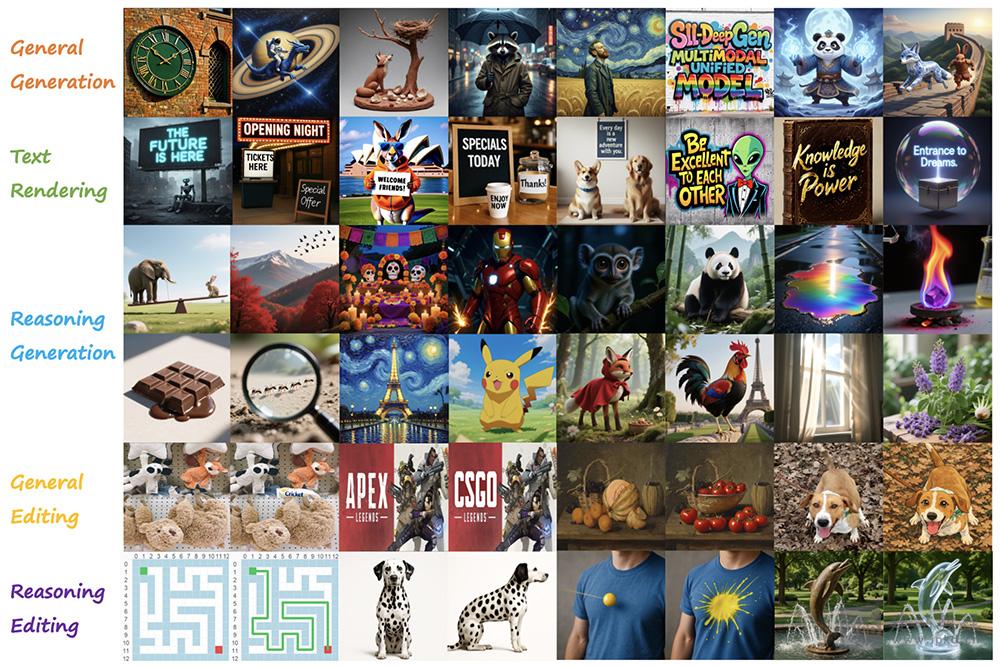

DeepGen 1.0是由中国科学技术大学、西湖大学与南加州大学等联合推出的轻量级统一多模态模型,仅50亿参数,却在通用图像生成、编辑及复杂逻辑理解任务中实现超越级表现,多项指标击败参数量为其3–16倍的国际顶级模型。

BitDance是字节跳动正式开源的140亿参数离散自回归多模态基础模型。凭借创新的二进制Token编码机制与并行扩散预测范式,模型在保持高分辨率、高保真画质的前提下,实现了颠覆性的生成速度,效率较传统自回归模型提升30倍以上,甚至超越多款主流扩散模型。

Ovis2.6-30B-A3B核心升级为MoE架构,实现300亿总参数与仅30亿激活参数的平衡,兼顾大模型能力与小模型推理成本;MoE架构提效降本、64K长上下文+高清图像处理、主动式图像思考、强化的OCR/文档/图表理解。

Codev GGUF是一款基于Qwen2.5-VL-7B-Instruct微调而成的70亿参数视觉语言模型,通过“监督微调(SFT)+ 基于工具感知策略优化(TAPO)的强化学习(RL)”两阶段精准训练,核心目标是实现可靠、可解释的视觉推理。

Qwen2.5-Omni是阿里云通义千问的新一代端到端多模态旗舰模型,支持文本/图像/音频/视频全输入,可同步输出文本+自然语音,性能超越同规模单模态模型且已全平台开源。

Computer-Using Agent是OpenAI开发的先进人工智能模型,融合GPT-4o的视觉能力与强化学习驱动的高级推理能力。它可像人类一样与图形用户界面直接交互,无需依赖特定操作系统API或网络接口,灵活性极强,能在多种数字环境中完成填写表单、网页浏览等任务。

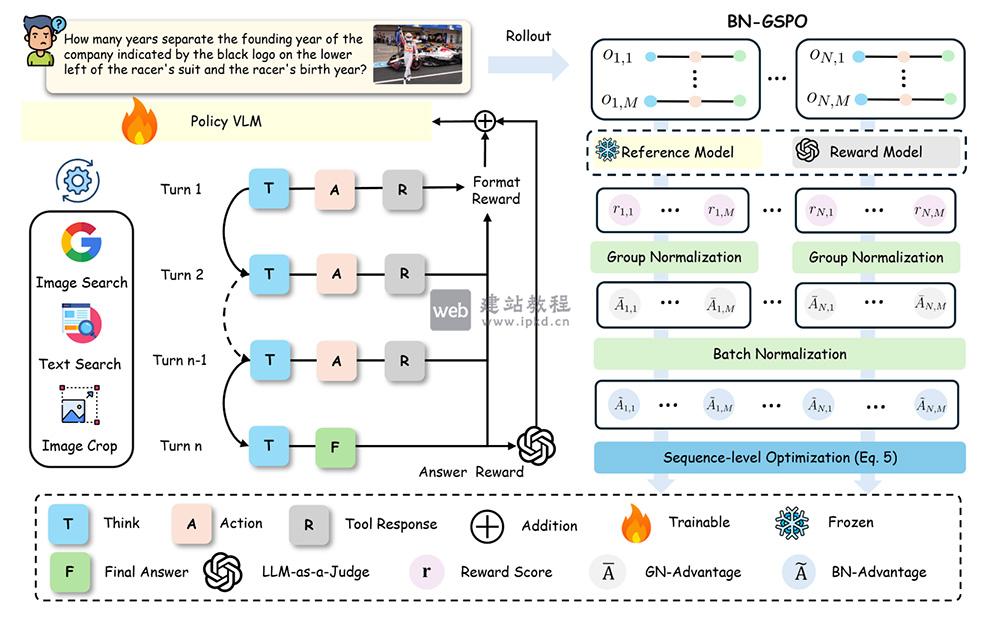

SenseNova-MARS模型可像智能体一样自主规划任务步骤,灵活调用图像裁剪、文本搜索、图像搜索三大工具,无需人工干预即可完成复杂多跳推理。

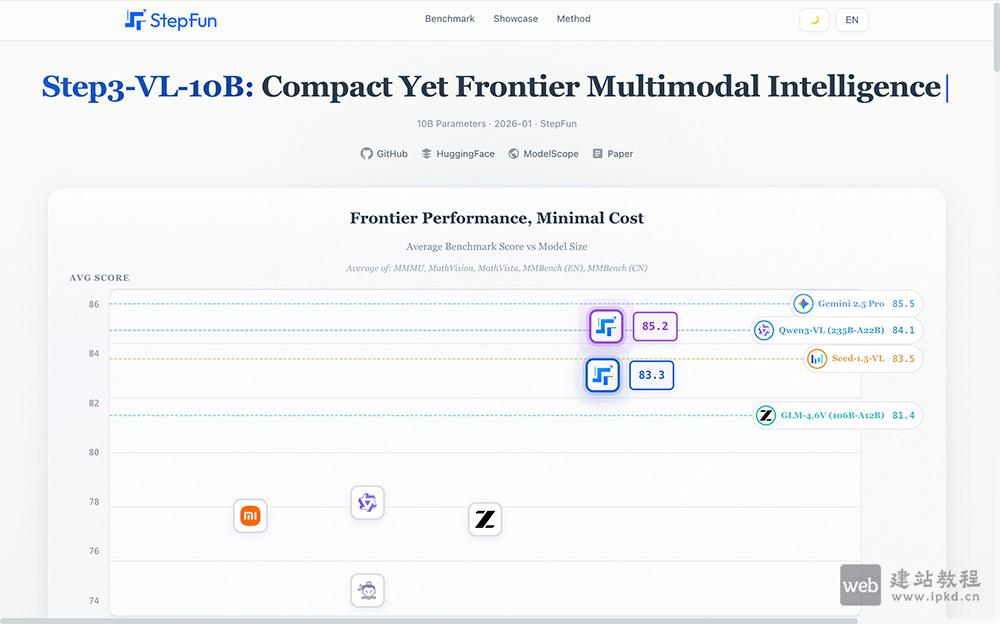

Step3-VL-10B是阶跃星辰推出的轻量级开源多模态模型,仅搭载10B参数,却能在视觉感知、逻辑推理、数学竞赛及通用对话等核心任务中,达到200B大参数模型的性能水准。

LLaVA-OneVision-1.5在多模态权威基准测试中表现优异,且全链条技术资源透明开放,代码、数据与模型权重一键获取,助力开发者低成本复现与二次创新。

openPangu-VL-7B是华为推出的开源多模态大模型,深度适配昇腾硬件架构,融合强大的语言理解与视觉分析能力,兼具高精度视觉定位、智能OCR识别等核心功能,可高效处理图像、文档、短视频等多类型任务。