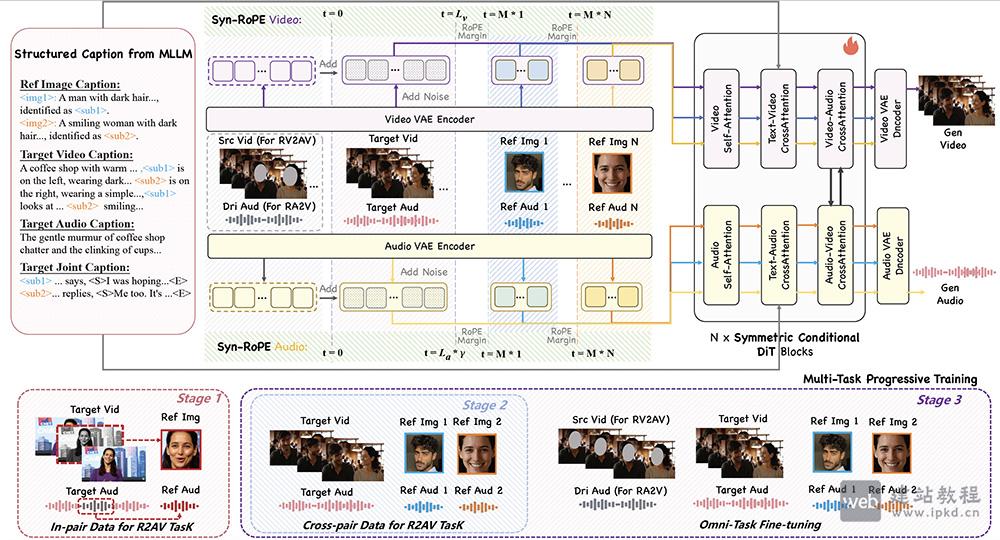

DreamID-Omni是由清华大学与字节跳动联合研发的统一、可控、以人为中心的音视频生成框架。它打破传统AI视频工具任务割裂的局限,在单一模型内同时实现参考生成、视频编辑、音频驱动动画三大核心能力,多项指标超越主流商业闭源模型,实现了端到端统一架构的重大突破。

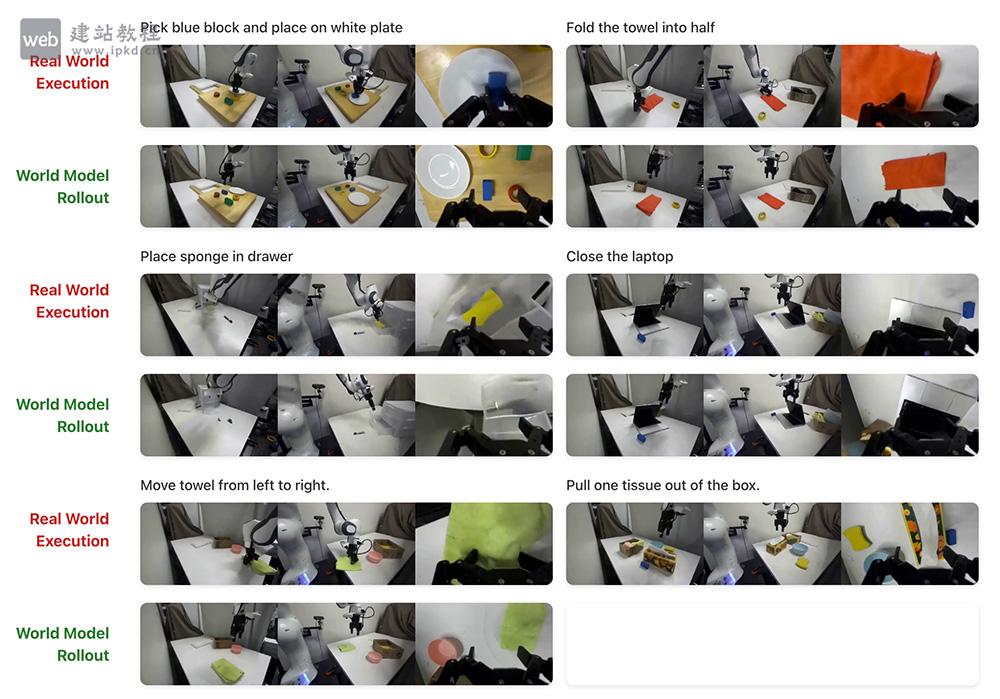

Ctrl-World是清华大学陈建宇团队与斯坦福大学Chelsea Finn团队联合研发的具身世界模型,模型创新性融合动作条件化架构与物理引擎约束,将机械臂动作参数显式注入生成流程,实现厘米级轨迹精度、0.986策略评估一致性及0.93深度准确性。

AgentCPM-Report是由清华大学自然语言处理实验室、中国人民大学、面壁智能与OpenBMB开源社区联合研发的本地化深度调研智能体,基于8B参数的MiniCPM4.1模型打造。

C-Eval是由上海交通大学、清华大学与爱丁堡大学研究团队于2023年5月联合推出的中文大语言模型专属评估套件,包含13948道标准化多项选择题,覆盖52个学科领域、划分四个难度等级。

DiaMoE-TTS是清华大学与巨人网络联合研发的多方言语音合成框架,框架创新性采用国际音标统一输入体系,融合方言感知的混合专家(MoE)架构与低资源适配策略,实现低成本、低门槛的多方言语音合成。

VoxCPM支持零样本声音克隆,仅需一段参考音频,即可精准复刻说话者的音色、口音、情感语调等细微特征,生成高度逼真的个性化语音。其推理效率同样表现卓越,在NVIDIA RTX 4090 GPU上实时因子(RTF)低至0.17,完美满足实时交互场景需求。

AgentCPM-Explore是由清华、人大、面壁智能与OpenBMB开源社区联合研发的轻量级开源智能体模型。该模型仅依托4B参数规模,却在多项长程任务评测基准中超越同尺寸乃至更大参数量的模型,展现出极高的能力密度;同时支持超100轮稳定交互,具备强大的深度探索能力。

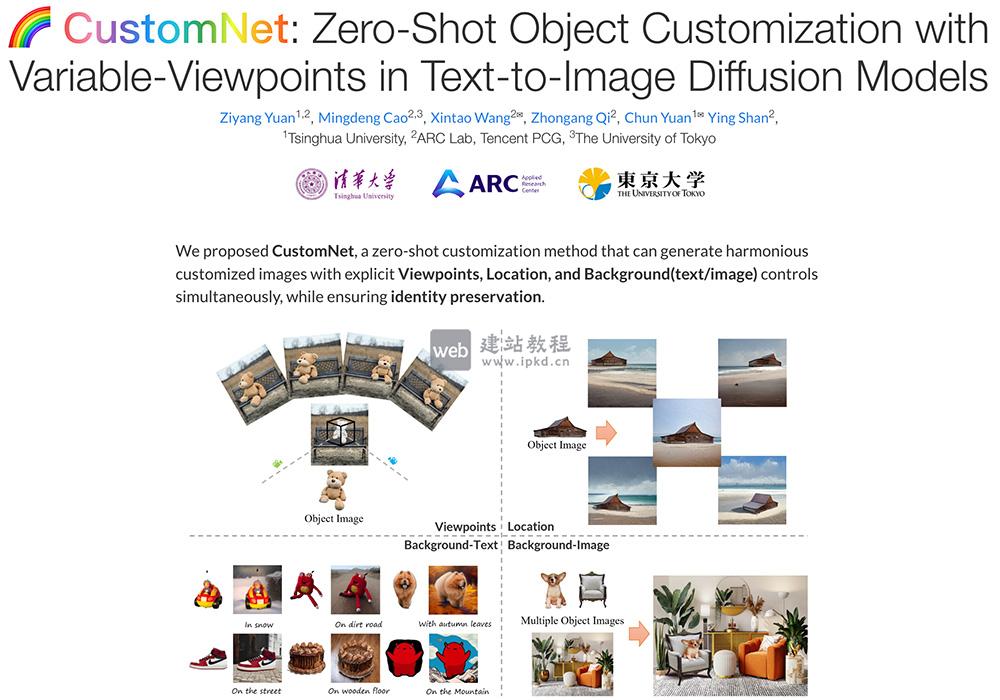

CustomNet是一个在文本到图像生成领域,将自定义对象(如特定商品)自然融入新场景并完整保留其样式、纹理细节,是极具实用价值的核心需求——尤其为商品图融合、创意设计等场景提供了全新可能。

DreamTalk是由清华大学、阿里巴巴与华中科技大学联合开发的扩散模型驱动面部动画生成框架,核心能力是让静态人物照片“开口说话”,支持匹配歌曲、多语言语音、嘈杂音频等多种声音类型,生成的唇部动作与表情风格高度自然逼真,打破了传统照片说话技术对纯净音频、表情参考的依赖。

TurboDiffusion是由清华大学、生数科技与加州大学伯克利分校联合研发的重磅视频生成加速框架,凭借多项核心技术突破,实现视频生成效率的跨越式提升。框架创新性融合SageAttention、SLA(稀疏线性注意力)与rCM(时间步蒸馏

学堂在线运行了来自清华大学、北京大学、复旦大学、中国科技大学以及麻省理工学院等国内外高校的约8000门优质课程,覆盖13大学科门类。

深言达意是一款由清华大学自然语言处理实验室和北京智源人工智能研究院孵化的智能写作辅助工具,旨在帮助用户通过模糊描述找到合适的词语和句子。该工具基于先进的人工智能算法,能够高效、准确地提供写作支持。

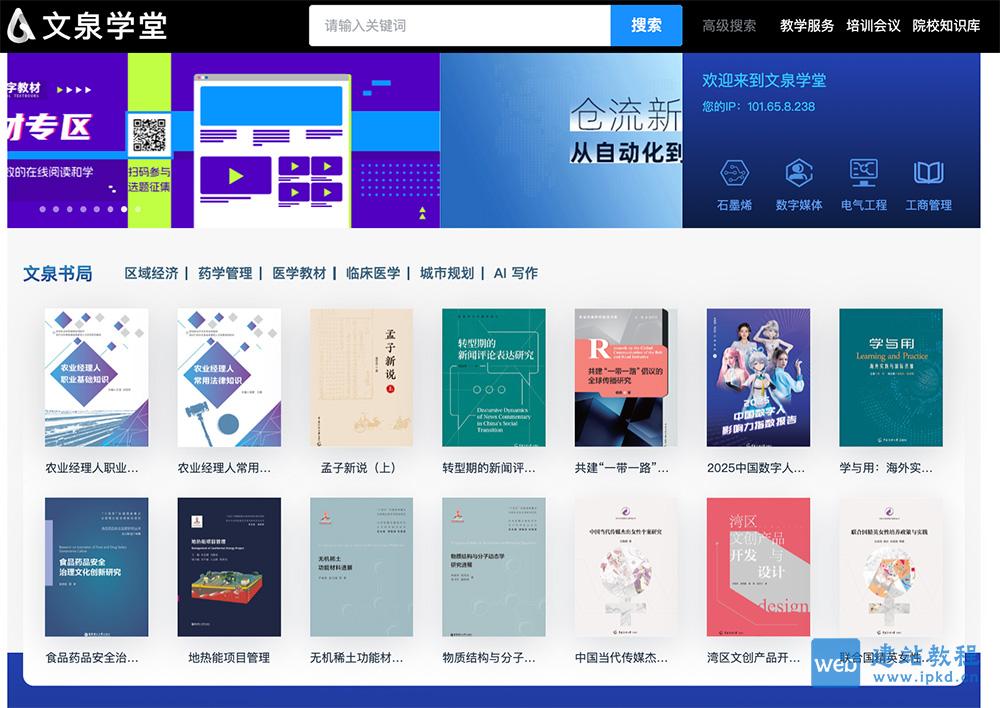

文泉学堂是以清华大学出版社联合多家大学出版社近10余年的正版电子书资源为基础,聚合了多媒体附件和特色课程内容资源,并内嵌了教师服务功能。

BizGen由清华大学与微软研究院联合推出,是一款强大的信息图生成工具。它能一键将长篇文章转化为专业级信息图和幻灯片,支持多语言和多种风格,排版精美,准确率高,广泛应用于商业汇报、产品展示、学术研究、社交媒体、教育课件和广告设计,助力用户高效呈现复杂信息。

支持语法优化、发音评估、记忆功能和个性化学习计划,提供沉浸式的场景练习和中英文混合输入功能,适合学生、职场人士和旅行者。无论是备考雅思、托福,还是提升日常交流能力。