Xiaomi-Robotics-0模型是小米开源的首代机器人VLA(视觉-语言-动作)大模型,搭载47亿参数,创新采用MoT混合架构——以Qwen3-VL多模态模型为“大脑”,负责解析视觉与语言指令、理解场景意图;以Diffusion Transformer(DiT)为“小脑”,专注生成高频平滑动作块。

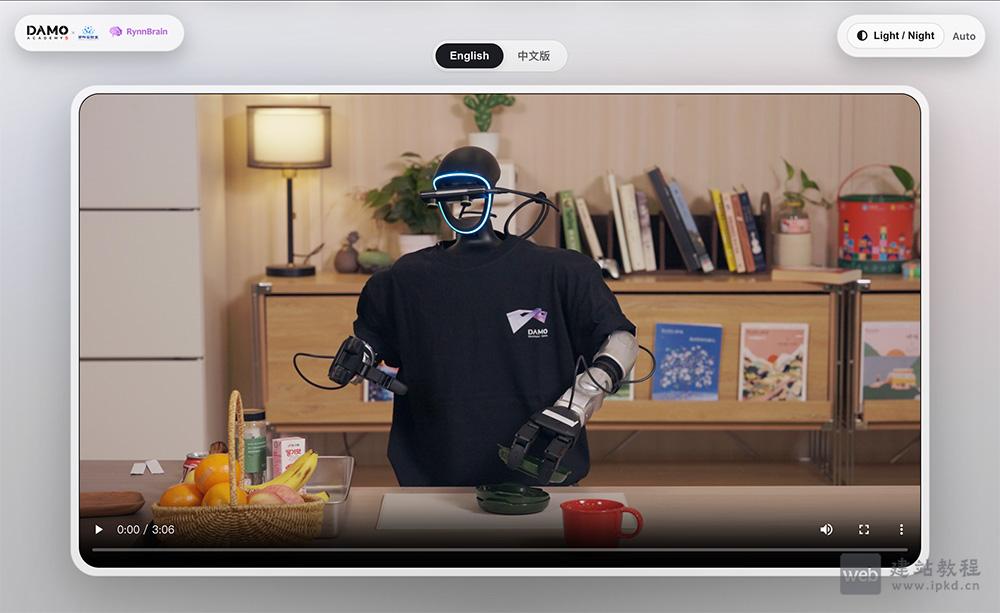

RynnBrain是阿里巴巴达摩院推出的开源具身智能大脑基础模型,基于Qwen3-VL训练并采用自研RynnScale架构,首次赋予机器人时空记忆与物理空间推理能力。

Qwen3-VL-32B-Thinking是基于原版Qwen3-VL-32B-Thinking打造的轻量化视觉语言模型,核心保留原版模型的视觉理解与文本生成能力,通过Int4量化技术大幅降低显存占用,打破硬件部署限制,让这款强大的跨模态模型能在更广泛的硬件环境中落地,兼顾性能与部署经济性,助力研究者与开发者轻松集成应用。

COTA是超参数科技研发的新型游戏智能体,以大语言模型(LLM)为核心驱动引擎,具备认知、操作、战术规划与辅助协作四大核心能力。

Qwen3-VL Cookbooks是阿里巴巴为Qwen3-VL多模态大模型量身打造的官方实战指南集合,指南覆盖物体识别、文档解析、视频理解、3D定位等十余类核心能力,每一份Cookbook均配套详细代码示例、分步操作教程与场景化最佳实践。

Qwen3-VL-Reranker是阿里通义基于 Qwen3-VL 架构打造的跨模态理解模型,专为多模态信息检索场景设计。模型可接收任意模态组合的查询与文档对(如图文查询匹配图文文档),通过单塔架构与交叉注意力机制深度解析语义关联,输出精准

Qwen3-VL-Embedding是阿里通义推出的多模态信息检索模型,专为文本、图像、可视化文档(图表 / 代码 / UI 组件等)、视频等多模态输入场景设计。